关于网站结构优化小技巧

2023-03-15•

围观热度 1678•建站知识

简单谈一下优化网站结构时增加网站收录的技巧,希望对读者有所帮助。

先来看一下如下图所示的内容,如果告诉我这是一位SEOer写的,那么我绝对不会相信。为什么呢?代码中存在大量的<iframe></iframe>框架结构,懂点SEO的人一定知道,这段代码是不可能进行蜘蛛爬行的。

下面通过介绍搜索引擎蜘蛛爬取和收录网页,来掌握相关的SEO技术,以免在搜索引擎优化过程中,犯类似上述的错误。

技巧1:了解爬取过程

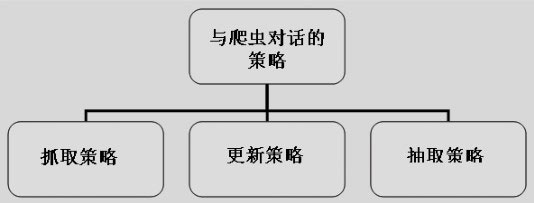

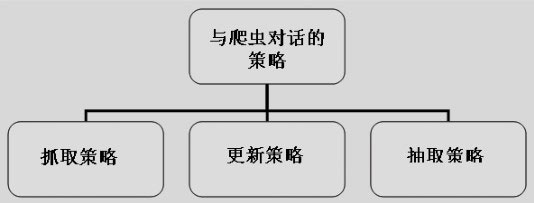

想要让爬虫(也就是蜘蛛)爬取和收录网页,需要有一定的策略。这如同做一件事情,要有一定的计划和安排,对付网络爬虫一定要有策略。策略有抓取、更新和抽取之分,具体情况如下图所示。

⑴抓取策略

随着网络技术的发展,网页的数量规模不断扩大,如此巨大的数据量,最终决定了爬虫所能抓取的网页数量只能是其所下载网络的一部分。因此,事先定义清除哪些网页需要下载,哪些不需要下载,哪些网页优先下载,能节省很多无谓的爬取。

⑵更新策略

编写搜索引擎程序的时候,需要判断一个网页是否已经更新。页面更新了需要重新下载,再次建立索引;若没有更新,则不用重新索引,从而节约系统资源。具体方法包括通过监控列表页来发现新的页面,定期检查(check)页面是否过期等。

⑶抽取策略

爬虫并不追求覆盖面大,而是将目标定为抓取与某一特定主题内容相关的网页,为面向主题的用户查询准备数据资源。此时需要考虑如何从网页中抽取想要的内容,不仅要包含最终的目标内容,还有下一步要抓取的URL。

技巧2:掌握抓取频率

除了前面提到的这几种相关策略,还需要注意爬虫的“抓取频率”。对于搜索引擎而言,爬虫效率的一个重要评价标准就是爬虫开销。Dasgupta等人将爬虫开销定义为:爬虫开销=重复抓取的老页面数/发掘的新页面数。

那么,爬虫的抓取频率以及效率该如何优化呢?下面进行具体介绍。

首先,以robots.txt命名的文本文件是个很强的利器,当网站上拥有重复内容、无内容且无意义页面等类似内容的时候,就可以果断地用robots.txt屏蔽掉。这里需要注意:robots.txt文件可以用通配符书写,书写是比较自由的。建议把xml格式的sitemap路径放在robots.txt文件中,供搜索引擎寻找。

其次,当需要合理地、有效率地下载一个网站时,设置参数nofollow,可以让百度搜索引擎不抓取页面上的所有链接。在robots.txt文件中添加rel=“noindex”语句,不能阻止百度爬虫抓取,因为noindex参数可以让搜索引擎不把当前网页置入索引库,但是页面上所有的链接,爬虫都会去分析。若要屏蔽链接,要加上nofollow参数。

总之,提高爬虫的抓取效率在SEO之中是一件比较重要的事情,尤其对于中大型网站而言,应该将大部分精力放在让爬虫抓取更多更准的页面上,而不是让它抓到无意义的页面。

建站咨询

建站咨询

SEO优化咨询

SEO优化咨询

小程序咨询

小程序咨询