蜘蛛的抓取方式

2023-02-15•

围观热度 2732•技术推荐

对于搜索引擎来说,要抓取互联网上所有的网页几乎是不可能的,从目前公布的数据来看,容量最大的搜索引擎也不过是抓取了全部网页数量的40%左右。这其中的原因一方面是抓取技术的瓶颈,蜘蛛无法遍历所有的网页,有许多网页无法从其他网页的链接中找到;另一方面是存储技术和处理技术的限制,如果按照每个页面平均大小为20KB来计算(包含图片),100亿个网页的容量就接近200000GB,即使能够存储如此庞大的数据量,其下载也是个问题(按照一台机器每秒下载20KB来计算,需要240台机器不停地下载一年的时间,才能把所有的网页下载完毕)。

同时,由于数据量太大,在提供搜索时也会有效率方面的影响。因此,许多搜索引擎的蜘蛛只抓取那些重要的网页,而在抓取的时候评价重要性主要的依据是网页的链接深度。在抓取网页的时候,蜘蛛一般有两种策略:广度优先和深度优先。

广度优先是指蜘蛛会先抓取起始网页中链接的所有网页,然后再选择其中的一个链接网页,继续抓取在此网页中链接的所有网页。这是最常用的方式,因为这个方法可以让蜘蛛并行处理,提高其抓取速度。深度优先是指蜘蛛会从起始页开始,一个链接一个链接地跟踪下去,处理完这条线路之后再转入下一个起始页,继续跟踪链接。这种方法的优点是蜘蛛在设计的时候比较容易。

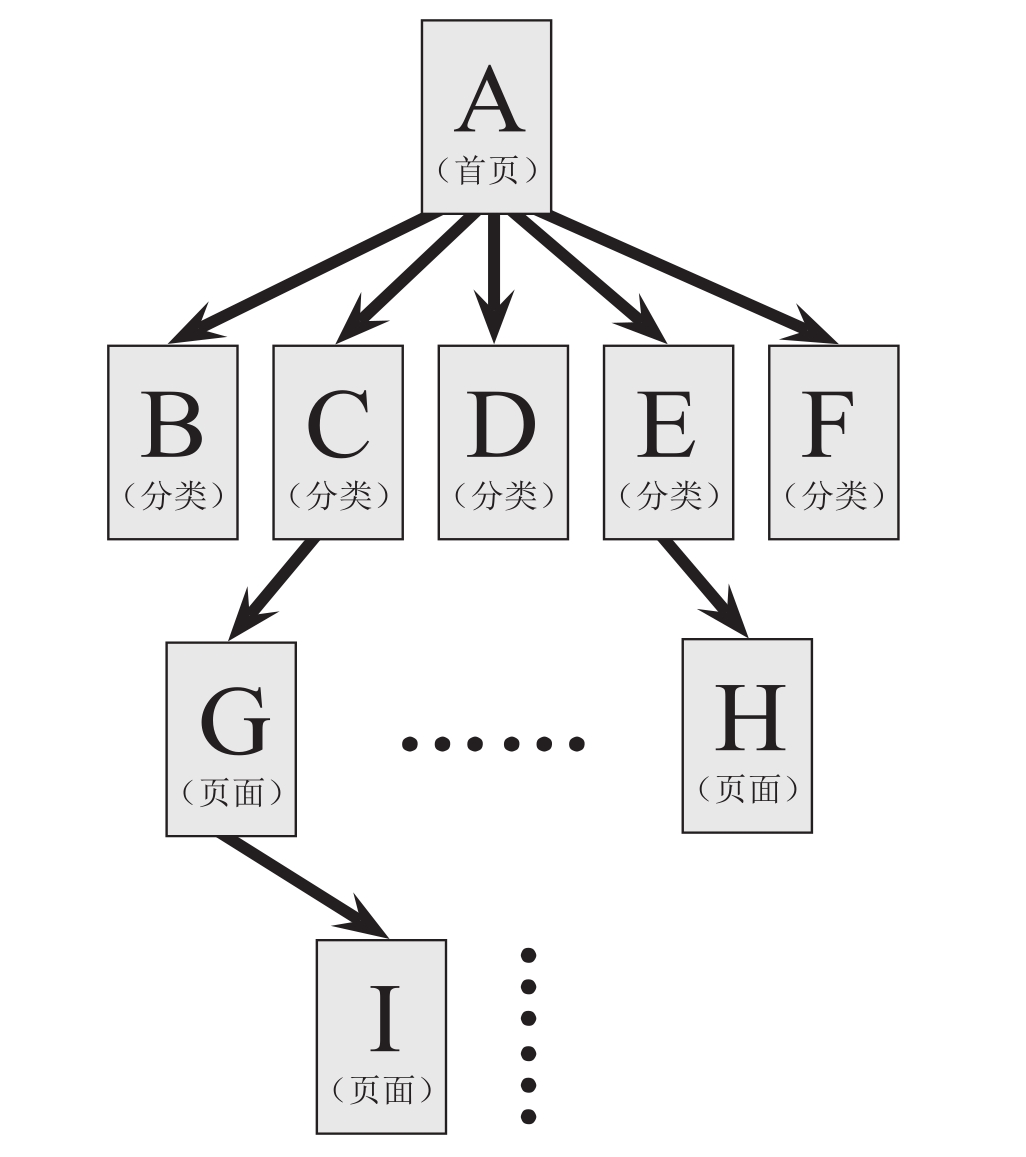

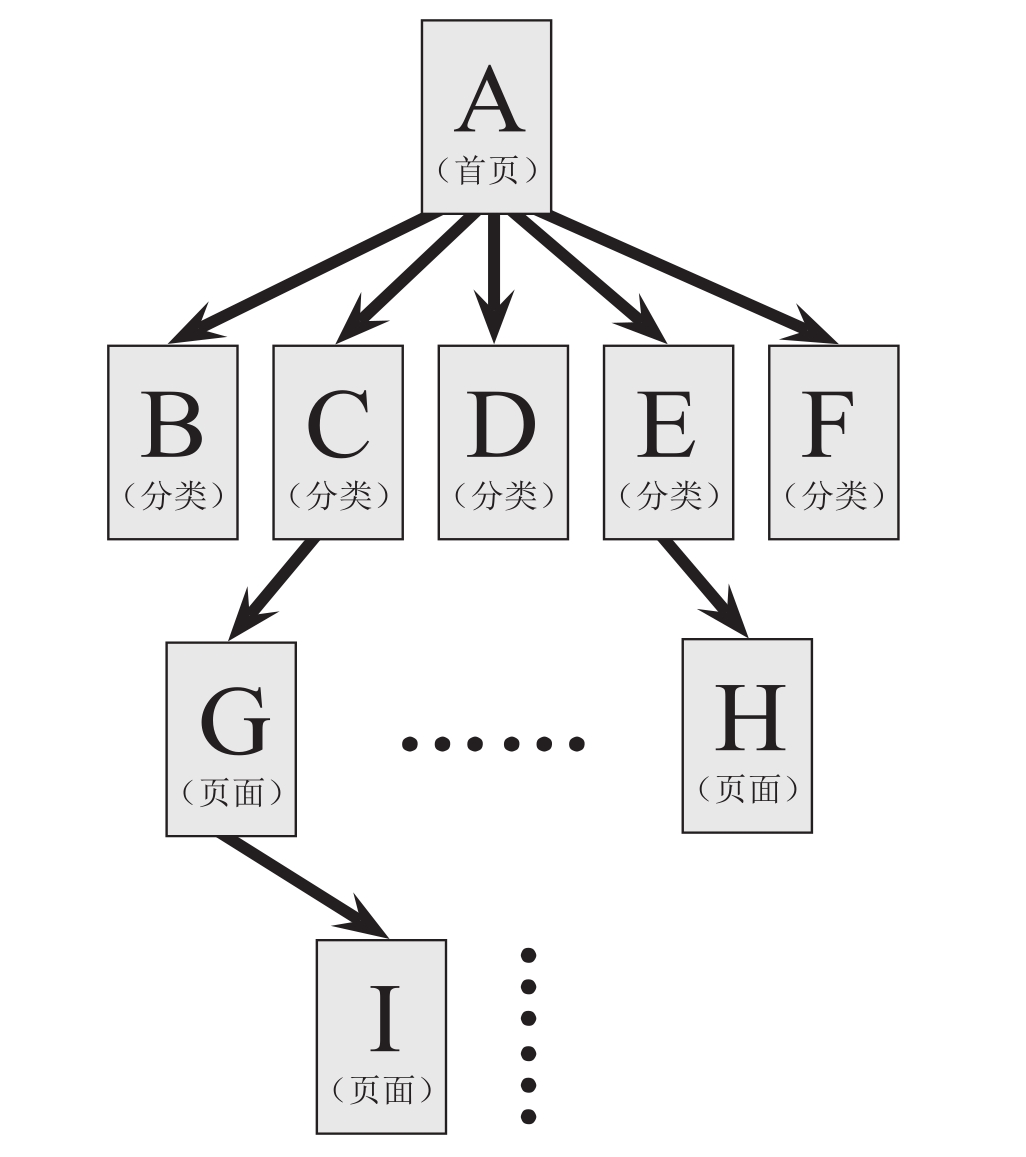

考虑到不可能抓取所有的网页,有些蜘蛛对一些不太重要的网站设置了访问的层数,如图2-1所示。其中A为起始网页,属于第0层,B、C、D、E、F属于第1层,G、H属于第2层,I属于第3层。如果蜘蛛设置的访问层数为2的话,网页I是不会被访问到的。这使得有些网站上的一部分网页在搜索引擎上能被搜索到,另外一部分则不能被搜索到。对于网站设计者来说,扁平化的网站结构设计有助于搜索引擎抓取其更多的网页。

蜘蛛在访问网站和网页的时候,经常会遇到加密数据和网页权限的问题,有些网页是需要会员权限才能访问的。当然,网站的所有者可以通过协议让蜘蛛不进行抓取,但对于一些出售报告的网站,它们希望搜索引擎能搜索到它们的报告,但又不能完全免费地让搜索者查看,这样就需要给蜘蛛提供相应的用户名和密码。蜘蛛可以通过所给的权限对这些网页进行网页抓取,从而提供搜索服务。而当搜索者点击查看该网页的时候,同样需要搜索者提供相应的权限验证。

建站咨询

建站咨询

SEO优化咨询

SEO优化咨询

小程序咨询

小程序咨询